课程介绍

深度学习是一个专门研究发现和提取大型非结构化数据集中复杂结构的领域,用于对多层人工神经网络进行参数化。由于深度学习推动了许多研究和应用领域的最新发展,它已成为现代技术不可或缺的部分。

STAT453 课程的重点是通过将人工神经网络与统计学中的相关概念(如广义线性模型和最大似然估计)联系起来,深入理解人工神经网络。除了涵盖预测建模的深度学习模型外,本课程的后一部分将侧重于深度生成模型和基于随机变分推理的模型,这允许学习定向概率模型。

除了在数学和概念层面上涵盖和解释深度学习和生成模型外,本课程还强调深度学习的实践方面。Python科学计算开放源码生态系统的开放源码库将用于为学生提供实践经验,以实现深层神经网络,完成有监督的学习任务,并将生成模型应用于数据集合成。

课程学习结束后,学生能够掌握各类深度学习算法原理及其优缺点,深入理解深度学习和生成模型——这是当前预测建模最先进的方法,并掌握使用Python编程来解决现实问题的能力。课程对于构建深度学习知识储备与实战能力有很大帮助。

本门课程学习建议具有微积分和线性代数背景,强烈建议学生熟悉基本编程并已完成入门编程课程。

课程讲师 Sebastian Raschka 是威斯康辛大学麦迪逊分校统计学助理教授,专注于机器学习和深度学习研究,包括深度学习方法的开发和对计算机视觉和计算生物学的应用,初版了多门机器学习相关著作。

课程主题

STAT453 是威斯康星大学的深度学习和生成模型课程,从机器学习与深度学习的基础知识开始,给大家系统讲解了深度学习及其在视觉与文本数据中的典型模型与各种应用,并以 PyTorch 为主 AI 框架进行了实战代码讲解。课程官网发布了课程主题,ShowMeAI 对其进行了翻译。

- The History of Neural Networks and Deep Learning(深度学习简史)

- Single-layer Neural Networks(感知器讲座)

- Linear Algebra for Deep Learning(深度学习的线性代数)

- Fitting Neurons with Gradient Descent(梯度下降)

- Automatic Differentiation with PyTorch(PyTorch 中的自动微分)

- Logistic Regression and Multi-class Classification(逻辑回归)

- Multilayer Perceptrons(多层感知器)

- Regularization(神经网络的正则化方法)

- Feature Normalization and Weight Initialization(输入归一化和权重初始化)

- Common Optimization Algorithms(改进基于梯度下降的优化)

- Convolutional Neural Networks(卷积神经网络)

- Recurrent Neural Networks(循环神经网络)

- Autoencoders(自编码器)

- Generative Adversarial Networks (GAN)(生成对抗网络简介)

课程资料 | 下载

|

扫描上方图片二维码,关注公众号并回复关键字 🎯『STAT453』,就可以获取整理完整的资料合辑啦!当然也可以点击 🎯 这里 查看更多课程的资料获取方式!

ShowMeAI 对课程资料进行了梳理,整理成这份完备且清晰的资料包:

- 📚 课件&代码。PDF文件、数据文件和.ipynb文件。(说明:课件Lecture编号至16,已是全部资料)

- 📚 作业。数据文件和.ipynb文件。覆盖Homework 1~3。

- 📚 拓展阅读资料。Python、PyTorch的安装和学习常见问题。

课程视频 | B站

ShowMeAI 将视频上传至B站,并增加了中英双语字幕,以提供更加友好的学习体验。点击页面视频,可以进行预览。推荐前往 👆 B站 观看完整课程视频哦!

本门课程,ShowMeAI 将部分章节进行了切分,按照主题形成更短小的视频片段,便于按照标题进行更快速的检索。视频数量很多,为方便大家检索(查找某主题的位置,请使用页面 Ctrl+F 关键字检索功能),依旧将完整清单放在这里:

| 课时编号 | 课时内容 |

|---|---|

| 第1.0讲 | 深度学习介绍&课程介绍 |

| 第1.1.1讲 | 课程概述第 1 部分:动机和主题 |

| 第1.1.2讲 | 课程概述第 2 部分:组织 |

| 第1.2讲 | 什么是机器学习? |

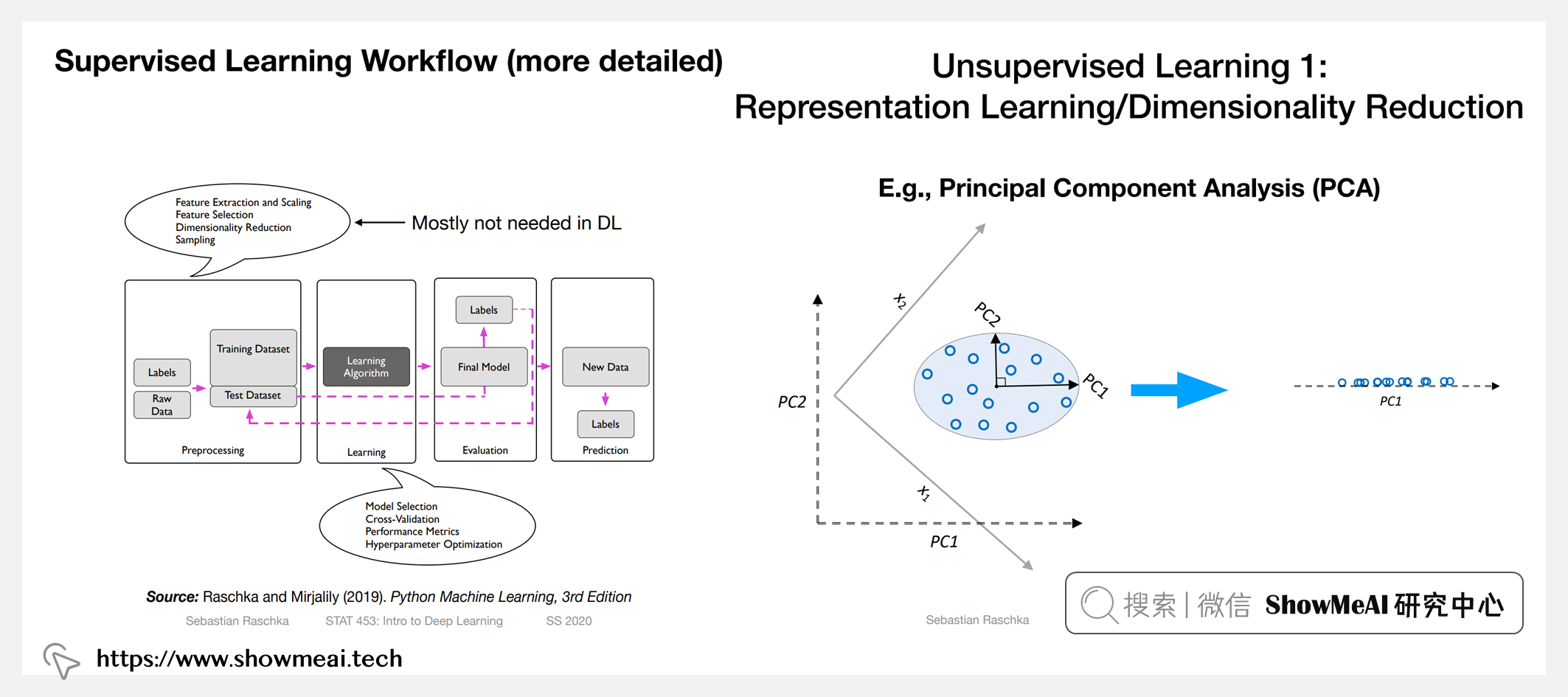

| 第1.3.1讲 | ML 的广泛类别第 1 部分:监督学习 |

| 第1.3.2讲 | ML 的广泛类别第 2 部分:无监督学习 |

| 第1.3.3讲 | ML 的广泛类别第 3 部分:强化学习 |

| 第1.3.4讲 | ML 的广泛类别第 4 部分:监督学习的特殊案例 |

| 第1.4讲 | 监督学习工作流程 |

| 第1.5讲 | 机器学习符号和专有名词 |

| 第1.6讲 | 关于本课程中使用的实践方面和工具 |

| 第2.0讲 | 深度学习简史【课程概述】 |

| 第2.1讲 | 人工神经元 |

| 第2.2讲 | 多层网络 |

| 第2.3讲 | 深度学习的起源 |

| 第2.4讲 | 深度学习硬件和软件一览 |

| 第2.5讲 | 深度学习的当前趋势 |

| 第3.0讲 | 感知器讲座概述 |

| 第3.1讲 | 关于大脑和神经元 |

| 第3.2讲 | 感知器学习规则 |

| 第3.3讲 | Python 中的向量化 |

| 第3.4讲 | Python 中使用 NumPy 和 PyTorch 构建感知器 |

| 第3.5讲 | 感知器背后的几何直觉 |

| 第4.0讲 | 深度学习的线性代数【课程概述】 |

| 第4.1讲 | 深度学习中的张量 |

| 第4.2讲 | PyTorch 中的张量 |

| 第4.3讲 | 向量、矩阵和广播 |

| 第4.4讲 | 神经网络的符号约定 |

| 第4.5讲 | PyTorch 中的全连接(线性)层 |

| 第5.0讲 | 梯度下降【课程概述】 |

| 第5.1讲 | 在线、批处理和小批量模式 |

| 第5.2讲 | 感知器和线性回归之间的关系 |

| 第5.3讲 | 线性回归的迭代训练算法 |

| 第5.4- (选修)微积分复习 I讲 | 导数 |

| 第5.5- (选修)微积分复习 II讲 | 梯度 |

| 第5.6讲 | 理解梯度下降 |

| 第5.7讲 | 训练自适应线性神经元 (Adaline) |

| 第5.8讲 | Adaline 代码示例 |

| 第6.0讲 | PyTorch 中的自动微分【课程概述】 |

| 第6.1讲 | 了解有关 PyTorch 的更多信息 |

| 第6.2讲 | 理解基于计算图的自动微分 |

| 第6.3讲 | PyTorch 中的自动微分 |

| 第6.4讲 | 使用 PyTorch 训练 ADALINE |

| 第6.5讲 | 深入了解 PyTorch API |

| 第7.0讲 | GPU 资源和 Google Colab |

| 第8.0讲 | 逻辑回归【课程概述】 |

| 第8.1讲 | 逻辑回归作为单层神经网络 |

| 第8.2讲 | 逻辑回归损失函数 |

| 第8.3讲 | Logistic 回归损失导数和训练 |

| 第8.4讲 | Logits 和交叉熵 |

| 第8.5- PyTorch 中的逻辑回归 讲 | 代码示例 |

| 第8.6讲 | 多项 Logistic 回归/Softmax 回归 |

| 第8.7.1讲 | OneHot 编码和多类别交叉熵 |

| 第8.7.2讲 | OneHot 编码和多类别交叉熵代码示例 |

| 第8.8讲 | 梯度下降的 Softmax 回归导数 |

| 第8.9讲 | 使用 PyTorch 的 Softmax 回归代码示例 |

| 第9.0讲 | 多层感知器【课程概述】 |

| 第9.1讲 | 多层感知器结构 |

| 第9.2讲 | 非线性激活函数 |

| 第9.3.1讲 | 多层感知器代码第 1/3 部分(幻灯片概述) |

| 第9.3.2讲 | PyTorch Part 2/3 中的多层感知器(Jupyter Notebook) |

| 第9.3.3讲 | PyTorch 第 3/3 部分中的多层感知器(脚本设置) |

| 第9.4讲 | 过拟合和欠拟合 |

| 第9.5.1讲 | 猫狗和自定义数据加载器 |

| 第9.5.2讲 | PyTorch 中的自定义数据加载器(代码示例) |

| 第10.0讲 | 神经网络的正则化方法【课程概述】 |

| 第10.1讲 | 减少过拟合的技术 |

| 第10.2讲 | PyTorch 中的数据增强 |

| 第10.3讲 | 提前停止 |

| 第10.4讲 | 神经网络的 L2 正则化 |

| 第10.5.1讲 | Dropout 背后的主要概念 |

| 第10.5.2讲 | Dropout 共适应解释 |

| 第10.5.3讲 | (选修)Dropout 集成解释 |

| 第10.5.4讲 | PyTorch 中的 Dropout |

| 第11.0讲 | 输入归一化和权重初始化【课程概述】 |

| 第11.1讲 | 输入规范化 |

| 第11.2讲 | BatchNorm 的工作原理 |

| 第11.3讲 | PyTorch 中的 BatchNorm |

| 第11.4讲 | 为什么 BatchNorm 有效 |

| 第11.5- 权重初始化 讲 | 我们为什么要关心? |

| 第11.6讲 | Xavier Glorot 和 Kaiming He 初始化 |

| 第11.7讲 | PyTorch 中的权重初始化 |

| 第12.0讲 | 改进基于梯度下降的优化【课程概述】 |

| 第12.1讲 | 学习率衰减 |

| 第12.2讲 | PyTorch 中的学习率调度器 |

| 第12.3讲 | 具有动量的新元 |

| 第12.4讲 | Adam:结合自适应学习率和动量 |

| 第12.5讲 | 在 PyTorch 中选择不同的优化器 |

| 第12.6讲 | 关于优化算法的附加主题和研究 |

| 第13.0讲 | 卷积网络简介【课程概述】 |

| 第13.1讲 | CNN 的常见应用 |

| 第13.2讲 | 图像分类的挑战 |

| 第13.3讲 | 卷积神经网络基础 |

| 第13.4讲 | 卷积滤波器和权重共享 |

| 第13.5讲 | 互相关与卷积 |

| 第13.6讲 | CNN 和反向传播 |

| 第13.7讲 | CNN 架构和 AlexNet |

| 第13.8讲 | CNN 能看到什么 |

| 第13.9.1讲 | PyTorch 中的 LeNet-5 |

| 第13.9.2讲 | 在 PyTorch 中保存和加载模型 |

| 第13.9.3讲 | PyTorch 中的 AlexNet |

| 第14.0讲 | 卷积神经网络架构【课程概述】 |

| 第14.1讲 | 卷积和填充 |

| 第14.2讲 | 空间丢失和 BatchNorm |

| 第14.3讲 | 架构概述 |

| 第14.3.1.1讲 | VGG16 概述 |

| 第14.3.1.2讲 | PyTorch 中的 VGG16 |

| 第14.3.2.1讲 | ResNet 概述 |

| 第14.3.2.2讲 | PyTorch 中的 ResNet-34 |

| 第14.4.1讲 | 用卷积层代替最大池化 |

| 第14.4.2讲 | PyTorch 中的全卷积网络 |

| 第14.5讲 | 卷积而不是全连接层 |

| 第14.6.1讲 | 迁移学习 |

| 第14.6.2讲 | PyTorch 中的迁移学习 |

| 第15.0讲 | 循环神经网络简介【课程概述】 |

| 第15.1讲 | 处理文本数据的不同方法 |

| 第15.2讲 | 使用 RNN 进行序列建模 |

| 第15.3讲 | 不同类型的序列建模任务 |

| 第15.4讲 | 时间反向传播概述 |

| 第15.5讲 | 长短期记忆 |

| 第15.6讲 | 用于分类的 RNN:多对一结构RNN |

| 第15.7讲 | PyTorch 中的 RNN 情感分类器 |

| 第16.0讲 | 自编码器简介【课程概述】 |

| 第16.1讲 | 降维 |

| 第16.2讲 | 完全连接的自编码器 |

| 第16.3讲 | 卷积自编码器和转置卷积 |

| 第16.4讲 | PyTorch 中的卷积自动编码器 |

| 第16.5讲 | 其他类型的自动编码器 |

| 第17.0讲 | 变分自编码器简介【课程概述】 |

| 第17.1讲 | 变分自编码器概述 |

| 第17.2讲 | 从变分自动编码器采样 |

| 第17.3讲 | Log-Var 技巧 |

| 第17.4讲 | 变分自编码器损失函数 |

| 第17.5讲 | PyTorch 中手写数字的变分自动编码器 |

| 第17.6讲 | PyTorch 中人脸图像的变分自动编码器 |

| 第17.7讲 | PyTorch 中的 VAE 潜在空间算法 |

| 第18.0讲 | 生成对抗网络简介 |

| 第18.1讲 | GAN 背后的主要思想 |

| 第18.2讲 | GAN 目标 |

| 第18.3讲 | 为实际使用修改 GAN 损失函数 |

| 第18.4讲 | 在 PyTorch 中生成手写数字的 GAN |

| 第18.5讲 | 让 GAN 发挥作用的技巧和窍门 |

| 第18.6讲 | 在 PyTorch 中生成人脸图像的 DCGAN |

| 第19.0讲 | 用于序列到序列建模的 RNN 和转换器 |

| 第19.1讲 | 使用单词和字符 RNN 生成序列 |

| 第19.2.1讲 | 在 PyTorch 中实现字符 RNN(概念) |

| 第19.2.2讲 | 在 PyTorch 中实现字符 RNN(代码示例) |

| 第19.3讲 | 具有注意力机制的 RNN |

| 第19.4.1讲 | 在没有 RNN 的情况下使用注意力:一种基本的自我注意力形式 |

| 第19.4.2讲 | 自注意力和缩放点积注意力 |

| 第19.4.3讲 | 多头注意力 |

| 第19.5.1讲 | Transformer 架构 |

| 第19.5.2.1讲 | 一些流行的Transformer 模型:BERT、GPT 和 BART【概述】 |

| 第19.5.2.2讲 | GPT-v1:成式预训练transformer |

| 第19.5.2.3- BERT讲 | 来自transformer的双向编码器表示 |

| 第19.5.2.4讲 | GPT-v2:语言模型是无监督的多任务学习者 |

| 第19.5.2.5讲 | GPT-v3:语言模型是少数据学习器(Few-Shot Learner) |

| 第19.5.2.6- BART讲 | 结合双向和自回归transformer |

| 第19.5.2.7- 结束语 讲 | transformers的近期增长趋势 |

| 第19.6讲 | 基于PyTorch 的 DistilBert 电影评论分类器 |

更多技术与课程清单 | 点击查看详细课程