课程介绍

自然语言处理(NLP)是信息时代最重要的技术之一,也是人工智能的重要组成部分。NLP的应用无处不在,因为人们几乎用语言交流一切:网络信息浏览、搜索引擎、电子邮件、智能语音助手、智能客服、语言翻译、医疗报告等。近年来,深度学习方法在许多不同的NLP任务中获得了极佳的效果。

斯坦福大学的课程CS224n——自然语言处理与深度学习,正是围绕使用深度学习解决NLP问题为主题构建的高质量课程,主讲人是斯坦福大学Chris Manning,他是斯坦福大学机器学习教授,语言学和计算机科学教授,斯坦福人工智能实验室(SAIL)主任,以人为本的人工智能研究所副所长。

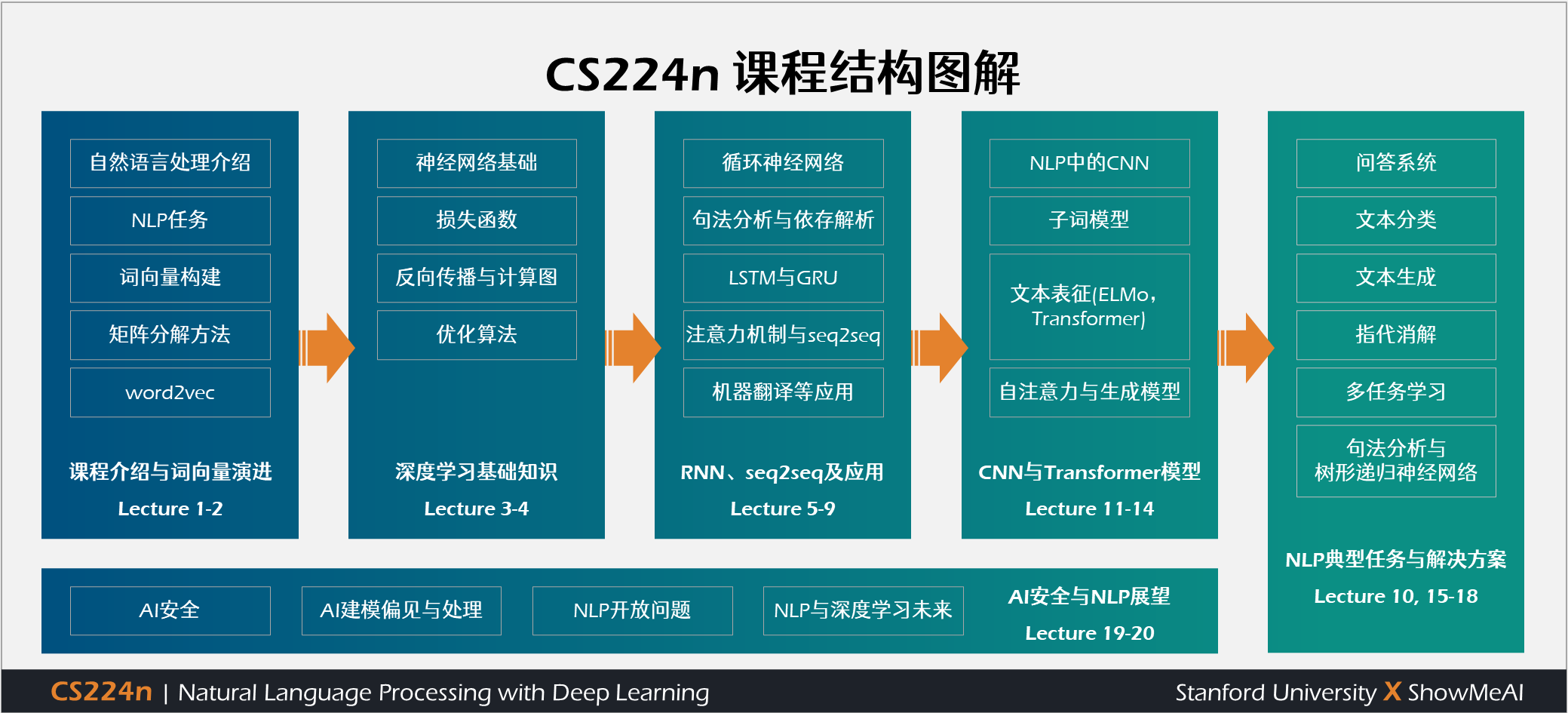

课程内容覆盖:字词句等文本编码方法、循环神经网络(RNN、LSTM及变种)、卷积神经网络(textCNN及变种)、transformer自注意力与BERT、自然语言处理预训练模型等知识。课程也讲解了文本分类、命名实体识别、句法解析、指代消解、问答系统、神经网络文本生成、摘要生成等NLP应用领域相关方法和案例。

前置基础

学生应具有以下背景:

- 机器学习基础。

- 熟悉概率理论(CS 109、MATH151 或 STAT116)。

- 熟悉多变量微积分和线性代数,熟悉(多变量)求导,理解矩阵/向量符号和操作。

- 精通Python。

课件动态注解 & 带学教程| 【点击课时】

| 课时编号 | PPT注解链接 | CS224n带学教程 |

| 第01讲 | 课程介绍与词向量初步 |  |

| 第02讲 | 词向量进阶 |  |

| 第03讲 | 神经网络知识回顾 |  |

| 第04讲 | 反向传播与计算图 |  |

| 第05讲 | 句法分析与依存解析 |  |

| 第06讲 | 循环神经网络与语言模型 |  |

| 第07讲 | 梯度消失问题与RNN变种 |  |

| 第08讲 | 机器翻译、seq2seq与注意力机制 |  |

| 第09讲 | 课程大项目实用技巧与经验 |  |

| 第10讲 | 问答系统 |  |

| 第11讲 | NLP中的卷积神经网络 |  |

| 第12讲 | 子词模型 |  |

| 第13讲 | 基于上下文的表征与NLP预训练模型(ELMo, transformer) |  |

| 第14讲 | Transformers自注意力与生成模型 |  |

| 第15讲 | NLP文本生成任务 |  |

| 第16讲 | 指代消解问题与神经网络方法 |  |

| 第17讲 | 多任务学习 |  |

| 第18讲 | 句法分析与树形递归神经网络 |  |

| 第19讲 | AI安全偏见与公平 |  |

| 第20讲 | NLP与深度学习的未来 |  |

官方笔记翻译 & 深度整理 |【点击编号】

| 笔记编号 | 在线笔记链接 | |

| 笔记1 | 词向量、SVD分解与word2vec |  |

| 笔记2 | GloVe及词向量的训练与评估 |  |

| 笔记3 | 神经网络与反向传播 |  |

| 笔记4 | 句法分析与依存解析 |  |

| 笔记5 | 语言模型、RNN、GRU与LSTM |  |

| 笔记6 | 神经机器翻译、seq2seq与注意力机制 |  |

| 笔记7 | 问答系统 |  |

| 笔记8 | NLP中的卷积神经网络 |  |

| 笔记9 | 句法分析与树形递归神经网络 |  |

作业代码解析 | 【点击编号】

| 作业编号 | solution地址 |

| 大作业1 | 词向量、SVD分解与word2vec |

| 大作业2 | GloVe及词向量的训练与评估 |

| 大作业3 | 神经网络与反向传播 |

| 大作业4 | 句法分析与依存解析 |

| 大作业5 | 语言模型、RNN、GRU与LSTM |

综合项目参考 | 【点击查看】

课程资料 | 下载

|

扫描上方图片二维码,关注公众号并回复关键字 🎯『CS224n』,就可以获取整理完整的资料合辑啦!当然也可以点击 🎯 这里 查看更多课程的资料获取方式!

ShowMeAI 对课程资料进行了梳理,整理成这份完备且清晰的资料包:

- 📚 课件-PDF。Lecture 1~20所有章节。课件细节丰富,制作者功力超强~

- 📚 课件注释-PDF。逐页添加中文注释,实现了网站动态翻页。细节也超丰富哦!快用起来吧!

- 📚 笔记-PDF。Note 1~9所有文档。图文并茂,可以有效辅助课程学习。

- 📚 笔记翻译-PDF。翻译上述全部Note,也制作了线上版哦!超酷的~

课程视频 | B站

ShowMeAI 将视频上传至B站,并增加了中英双语字幕,以提供更加友好的学习体验。点击页面视频,可以进行预览。推荐前往 👆 B站 观看完整课程视频哦!

本门课程,ShowMeAI 将部分章节进行了切分,按照主题形成更短小的视频片段,便于按照标题进行更快速的检索。切分后的视频清单列写在这里:

| 序号 | 视频章节 | 视频清单 |

|---|---|---|

| L1 | 第01讲 | 课程介绍与词向量初步 |

| L2 | 第02讲 | 词向量进阶 |

| L3 | 第03讲 | 神经网络知识回顾 |

| L4 | 第04讲 | 反向传播与计算图 |

| L5 | 第05讲 | 句法分析与依存解析 |

| L6 | 第06讲 | 循环神经网络与语言模型 |

| L7 | 第07讲 | 梯度消失问题与RNN变种 |

| L8 | 第08讲 | 机器翻译、seq2seq与注意力机制 |

| L9 | 第09讲 | 课程大项目实用技巧与经验 |

| L10 | 第10讲 | 问答系统 |

| L11 | 第11讲 | NLP中的卷积神经网络 |

| L12 | 第12讲 | 子词模型 |

| L13 | 第13讲 | 基于上下文的表征与NLP预训练模型(ELMo, transformer) |

| L14 | 第14讲 | Transformers自注意力与生成模型 |

| L15 | 第15讲 | NLP文本生成任务 |

| L16 | 第16讲 | 指代消解问题与神经网络方法 |

| L17 | 第09讲 | 多任务学习 |

| L18 | 第18讲 | 句法分析与树形递归神经网络 |

| L19 | 第19讲 | AI安全偏见与公平 |

| L20 | 第20讲 | NLP与深度学习的未来 |

更多技术与课程清单 | 点击查看详细课程